MLF SLAM とは

MLF SLAM (Multi-Level Fusion SLAM)は、センサ融合を高度に活用した自己位置推定と地図作成の手法です。従来のSLAM技術に比べて、より多様なセンサ情報を統合的に活用することで、過酷な環境や動的なシーンにおいても高い精度と安定性を実現します。

SLAMとは?

SLAM(Simultaneous Localization and Mapping)は、「自己位置推定」と「地図作成」を同時に行う技術であり、自動運転車、ドローン、ロボットなど、多くの自律システムの基盤技術です。たとえばロボットが初めての環境を走行する際、GPSが使えない屋内やトンネル内でも、周囲の情報から自分の位置を推定しながら、その環境の地図を作成する必要があります。これをリアルタイムで実現するのがSLAMの役割です。

MLF(Multi-Level Fusion)の特徴

MLF SLAM の「Multi-Level Fusion」は、複数のレベル(センサレベル、特徴レベル、マップレベル)での情報統合を意味します。これにより、以下のような特徴が得られます。

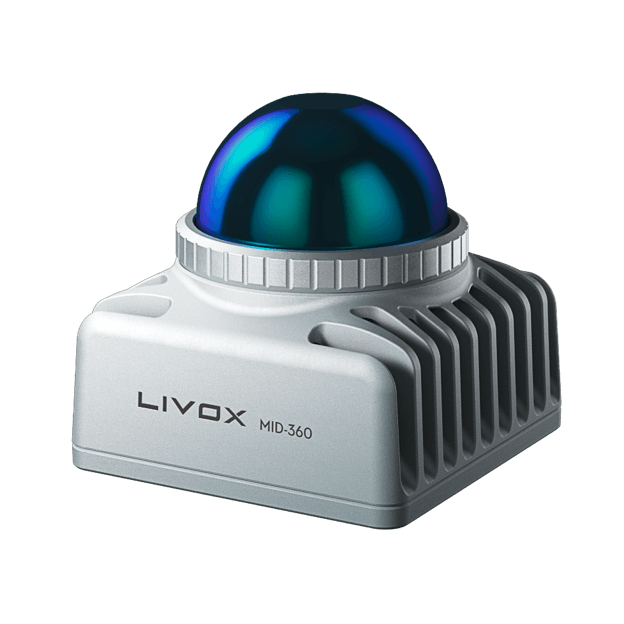

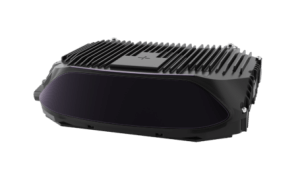

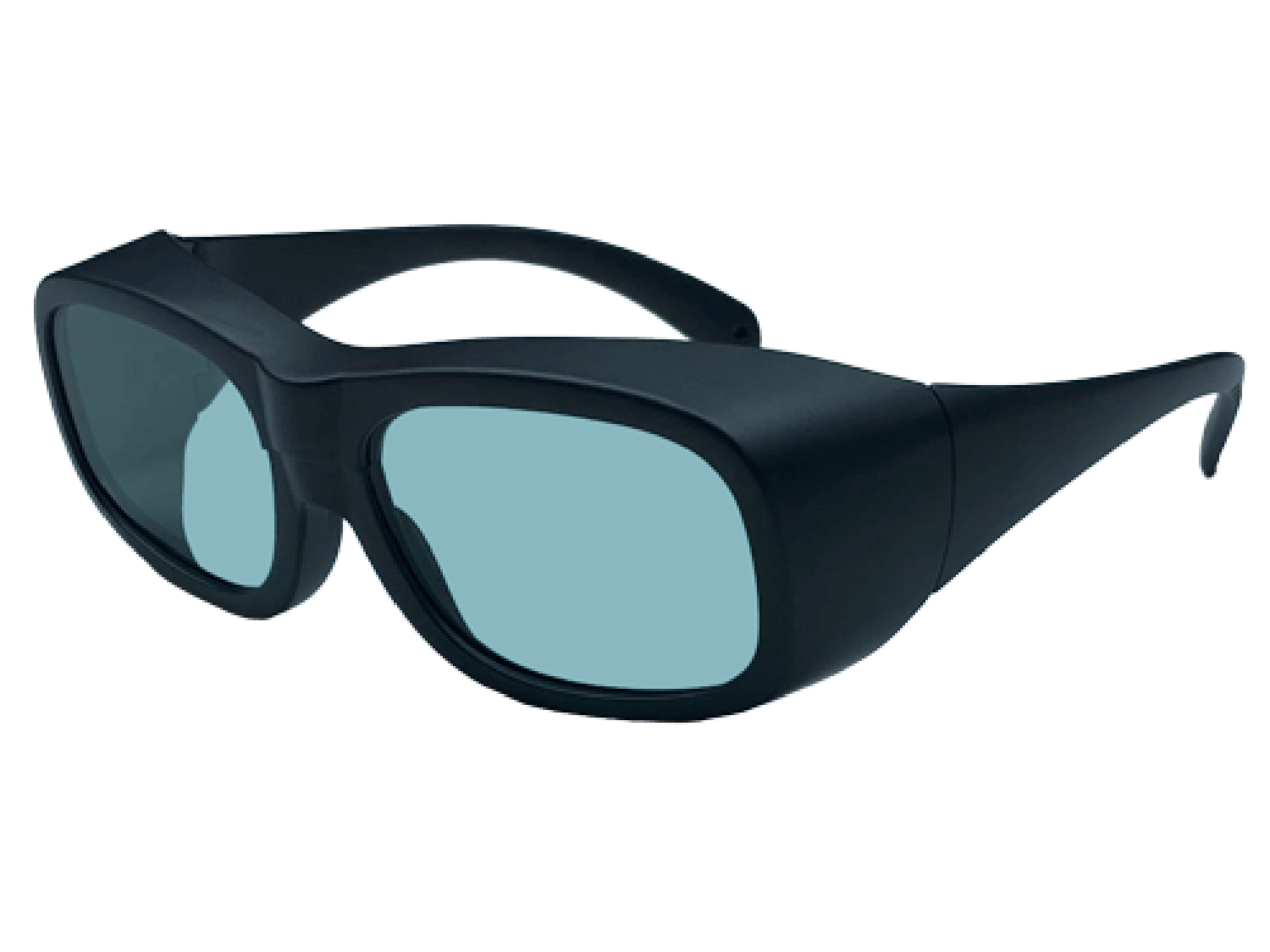

- センサ融合の柔軟性:LiDAR、カメラ、IMU、GPSなど異なる種類のセンサを組み合わせることで、各センサの弱点を補完

- 環境適応性:屋内外を問わず、照度変化や障害物の多いシーンでも高精度なマッピングが可能

- リアルタイム性能:最適化されたアルゴリズムにより、地図生成と自己位置推定を高速に実行

- 冗長性と信頼性:一部のセンサに障害が発生しても、他の情報源でカバー可能

センサーフュージョンとMLF SLAM

| 比較項目 | センサーフュージョン | MLF(Multi-Level Fusion) |

|---|---|---|

| 目的の違い | 複数のセンサーからのデータを統合して全体的な精度を向上させる。位置推定に限らず、環境認識、動作解析、物体認識など幅広い目的に利用される。 | 位置推定に特化し、複数のセンサーや手法から得られる位置情報を統合して、最適な自己位置を推定することが目的。 |

| データ統合の焦点 | センサーから得られるあらゆるデータ(位置、速度、環境情報など)を包括的に統合して、システム全体の認識精度を高める。 | 主に位置情報の統合に重点を置き、複数の位置推定結果を統合して、より精度の高い位置推定を実現する。 |

| 応用分野 | ロボティクス、自動運転、ドローン、物体認識、センサーネットワークなど、広範な分野に適用される。 | 自動運転車、ロボット、ドローンなどの自律ナビゲーションシステムで主に利用され、位置推定の精度向上に特化している。 |

まとめ

- MLF(-SLAM)は、センサーフュージョンの一形態である。

従来のSLAM と MLF SLAM の違い

| 項目 | 従来のSLAM | MLF SLAM(Multi-Level Fusion SLAM) |

|---|---|---|

| 使用センサ | 単一または少数のセンサ(例:カメラ、LiDAR) | 複数種類のセンサを統合(カメラ、LiDAR、IMU、GPSなど) |

| 情報の融合方法 | 単純なセンサデータ処理 | 複数のレベル(センサ・特徴・マップ)で高度に融合 |

| 環境への適応性 | 照明条件や環境の変化に弱い | 明るさの変化、障害物、動的環境に強い |

| 位置推定の安定性 | センサの特性に依存しやすい | 複数の情報を融合することでより安定 |

| 処理のリアルタイム性 | やや遅延が出る場合もある | 並列処理や軽量化でリアルタイム動作に最適化 |

| 応用の広がり | 比較的限定的(ロボットや一部の自動運転など) | より幅広い応用分野(建設、災害対応、空中測量など) |

まとめ

- SLAM :一つの目や耳を使って自分の位置を推測する方法

- MLF SLAM :複数の目・耳・センサーを連携させて、より正確に判断する方法

応用分野

- 自動運転車による高精度な自己位置認識

- 建設現場や工場内の移動ロボットナビゲーション

- ドローンを用いた空中測量・点検作業

- 災害現場などGPSが使えない環境での探索支援

まとめ

MLF SLAM は、マルチセンサの力を最大限に引き出し、複雑な環境でも安定した自己位置推定と高精度な地図作成を可能にする次世代のSLAM技術です。センサ融合の多層的なアプローチが、これまでSLAMが苦手としてきた状況でも、その性能を発揮しています。